A finales del mes del pasado mes de octubre de este año 2019, Google ha anunciado el uso de una nueva red neuronal de código abierto para el procesamiento de lenguaje natural llamada BERT. Es una actualización del algoritmo de Google que empezó el año pasado en fase de pruebas. En palabras del vicepresidente de Google Search, Pandu Nayak, el “mayor avance de los últimos cinco años” y uno “de los más grandes en la historia de Google Search”.

Como dice Nayak en un artículo en inglés, “un 15% de las consultas se hacen por primera vez, no se han hecho antes”. Por lo que el buscador ha desarrollado formas de devolver resultados para consultas que no se pueden anticipar. Y aunque los usuarios crean que el buscador entiende las cadenas de palabras clave que escriben, “a veces todavía no somos capaces de acertar y hacerlo del todo bien”.

¿Cómo se enfrenta Google Search a consultas en las que las palabras no se combinan bien porque el usuario no sabe exactamente cómo hacer la consulta? Teniendo en cuenta, como se ha destacado, que de miles de millones de consultas diarias, un 15% son consultas hechas por primera vez.

Lo hace con el desarrollo de BERT y la investigación de Google sobre transformers. Un avance que ha estado hasta el 9 de diciembre en marcha solo en la versión inglesa en Estados Unidos de Google Search. Y desde este día 9 de diciembre, en más de 70 países, como se anunció en la cuenta oficial de Twitter @searchliaison.

Nayak afirma que Google Search ha logrado “mejoras significativas” en idiomas como el coreano, el hindi y el portugués. Porque, tal y como asegura, la comprensión del lenguaje y de los matices de las consultas «sigue siendo un desafío continuo y nos mantiene motivados para continuar mejorando el buscador”.

Una característica poderosa de estos sistemas es que puede aprender de un idioma y aplicar esos conocimientos a otros. Por lo que podemos tomar modelos que aprenden de las mejoras en inglés (el idioma en el que está escrita la inmensa mayoría de los contenidos web) y aplicarlas a otros idiomas. Esto nos ayuda a devolver resultados de búsqueda mucho mejores y más relevantes en la multitud de idiomas en los que está disponible el buscador.

Nandu Payak, vicepresidente de Google Search

El objetivo de BERT y el algoritmo de Google

Tal y como explica Nayak, en la esencia de Google Search está comprender el lenguaje. Es decir, el trabajo del departamento de Google Search consiste en “descifrar lo que estás buscando y buscar información útil en la web, sin importar cómo lo escribas o combines las palabras en tu consulta”.

“Con los últimos avances de nuestro equipo de investigación en la ciencia de la comprensión del lenguaje, gracias al uso del machine learning, hemos hecho un significativo avance en cómo comprendemos las consultas, lo que representa el mayor salto hacia delante o avance en los últimos cinco años, y uno de los más grandes en la historia de Google Search”.

Pandu Nayak, vicepresidente de Google Search

El objetivo de Google es ofrecer información «útil» a las consultas de los usuarios y que estos escriban las consultas de la forma más natural posible. Aunque no siempre es fácil, sobre todo en consultas largas, conversacionales o en las que las preposiciones “para” o “a” tienen muchos significados posibles. Para estos casos, BERT y el algoritmo de Google favorecerá que el buscador sea “capaz de entender el contexto de las palabra en la consulta”. Pero, eso sí, estos modelos no son infalibles.

“No importa lo que estés buscando, o el idioma en el que hables, esperamos ser capaces de dejar de lado algunas keywords y hacer que el buscador trabaje de una forma que sea natural para ti. Pero, de todas formas, todavía tropezarás con Google de vez en cuando. Incluso con el uso de BERT, no siempre hacemos las cosas bien”, aclara Nayak.

BERT y transformers: Google Search desarrolla hardware nuevo

¿Qué son los transformers y por qué es BERT es la mayor actualización del algoritmo de Google? Nayak lo explica: los transformers son modelos que procesan o tratan las palabras relacionándolas con todas las demás palabras que hay en una frase, en lugar de una a una, por orden.

Esto significa que los modelos BERT “pueden considerar o tener en cuenta el contexto completo de una palabra viendo cuáles son las palabras que hay antes o después. Lo que resulta particularmente útil para saber la intención que hay detrás de las consultas en el buscador”. Para ello, añade, han tenido que desarrollar nuevo hardware.

“Algunos de los modelos que podemos construir con BERT son tan complejos que superan los límites de lo que podemos hacer usando hardware tradicional, por lo que por primera vez estamos usando lo último en Cloud TPUs para servir resultados de búsqueda y ofrecerte rápidamente la información más relevante”.

Pandu Nayak, vicepresidente del departamento de Google Search

Cómo Google entiende la intención de la consulta y contexto

Pandu Nayak, vicepresidente de Google Search, explica algunos ejemplos de cómo en el buscador en inglés se muestran resultados tratando de entender la intención de la consulta (si le interesa, aquí le explicamos el funcionamiento de Answer the Public en español y us importancia para detectar búsquedas long tail) Allá van tres de estos ejemplos:

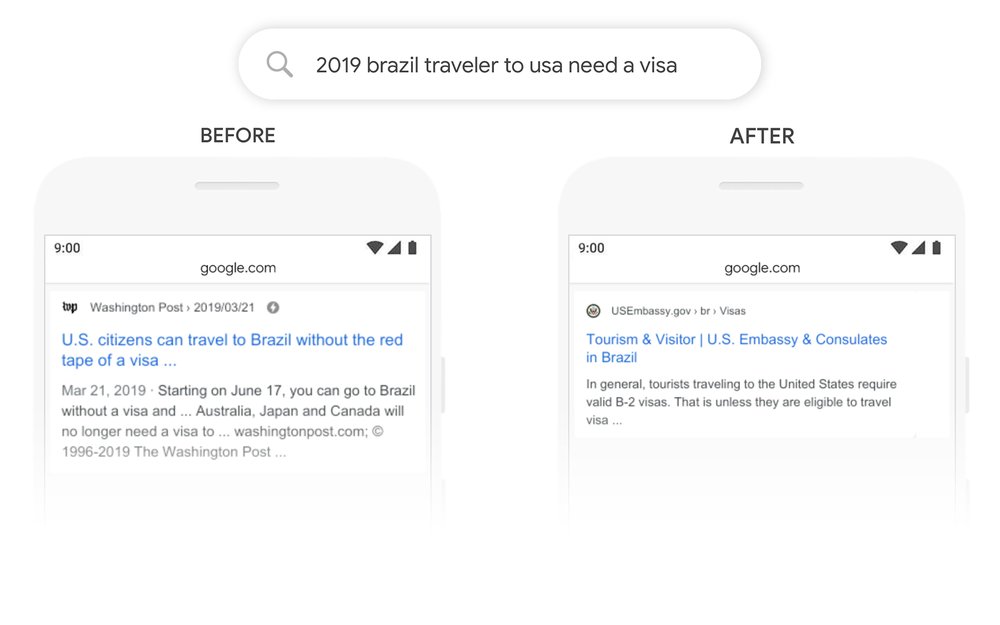

Consulta “2019 viajero Brasil a Estados Unidos necesita una visa”

He aquí una búsqueda “2019 brazil traveler to usa need a visa” (“2019 viajero Brasil a Estados Unidos necesita una Visa”). La palabra “a” y su relación con las demás en esta consulta son «particularmente importantes para entender el significado», dice Nayak. Se trata de una persona brasileña que va a viajar a Estados Unidos y no al revés. Anteriormente, “nuestros algoritmos no habrían podido comprender la importancia de esta conexión y devolvíamos resultados sobre ciudadanos estadounidenses que querían viajar a Brasil”, explica. Sin embargo, añade, “con BERT, el buscador de Google es capaz de comprender el matiz y saber que la palabra “a”, muy común, de hecho tiene mucha importancia, y podemos devolver un resultado mucho más relevante para esta consulta”.

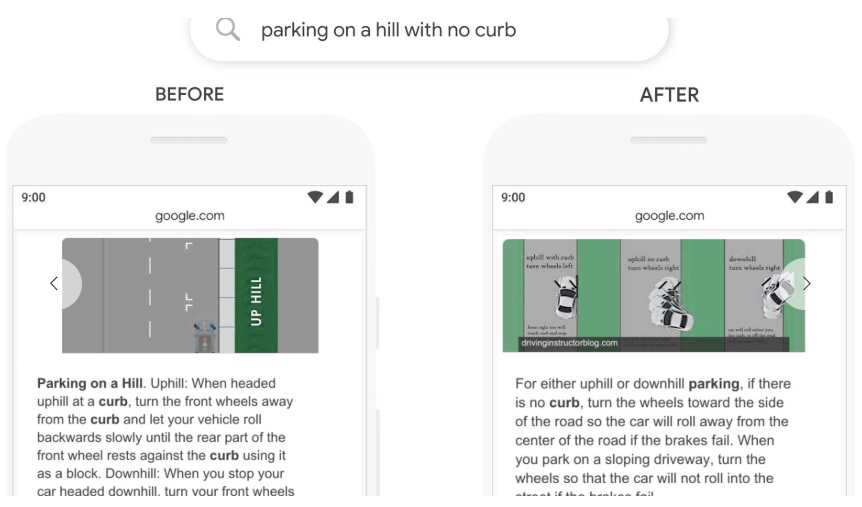

Consulta “Aparcar en una cuesta sin bordillo”

En el pasado, una consulta como esta «confundiría a nuestros sistemas porque dábamos demasiada importancia a la palabra “curb” (“bordillo”) e ignorábamos la palabra “no”, sin entender cómo de crítica o fundamental era esa palabra “no” para responder adecuadamente a esta consulta», explica. «¡Entonces devolvíamos resultados para aparcar en una cuesta con bordillo!».

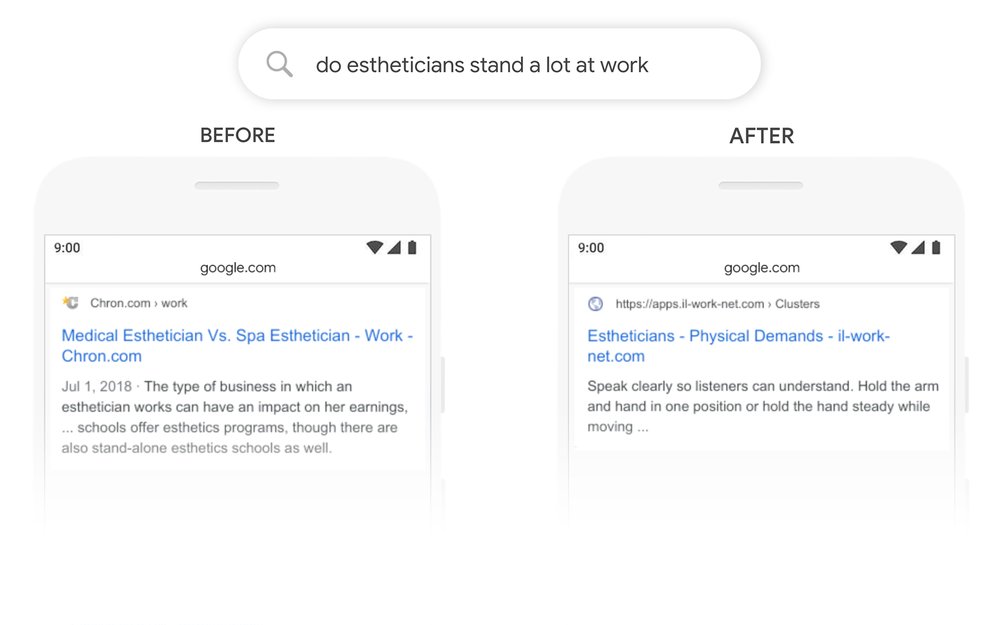

Consulta “Esteticistas están de pie mucho en el trabajo”

Esta es otra consulta con la que Nayak ejemplifica los cambios con BERT, última actualización del algoritmo de Google: “do estheticians stand a lot at work” («esteticistas están mucho de pie en el trabajo”). Previamente, explica, los sistemas de Google Search se enfocaban a unir las keywords, uniendo o asemejando el término “stand-alone” (“único”) en el resultado con la palabra “stand” en la consulta. “Pero este no era el uso correcto de la palabra “stand” en este contexto. Por el contrario, nuestros modelos BERT entienden que la palabra “stand” está relacionada con el concepto de las demandas físicas de un empleo o trabajo, y muestra de esta forma una respuesta mucho más útil”, señala Nayak.

Consecuencias de BERT y el algoritmo de Google en el SEO

Resumiéndolo: BERT pretende ser una revolución en cómo el algoritmo de Google comprende las consultas de los usuarios. Se escriba como se escriba una consulta, el buscador de Google devolverá resultados de búsqueda entendiendo todo el contexto y los matices del lenguaje.

Por lo que desde el punto de vista de la estrategia SEO, los generadores de contenidos deberán tenerlo en cuenta a la hora de escribir keywords o palabras clave en el contexto de los contenidos. Con esta última actualización del algoritmo de Google las palabras clave contextuales serán las que posicionarán mejor en los resultados de búsqueda.

Así lo explicaba en una entrevista concedida a Marketing Insider Review la Content Strategist de SEMrush para España y LATAM, Alicia Rodríguez.

Este cambio en el algoritmo de aprendizaje automático de Google y que está directamente relacionado con el procesamiento del lenguaje natural, busca comprender qué significan las palabras en una oración pero teniendo en cuenta todos los matices del contexto. Con esto se pone de relieve que las búsquedas de palabras clave tienden a ser cada más afinadas y totalmente enfocadas en devolver los resultados más óptimos para lo que el usuario busca. Así, donde antes una keyword raíz nos servía, ahora será una palabra clave contextual la que se posicione de mejor manera en los primeros resultados de Google. Con BERT el posicionamiento irá en función de todo el contexto y los contenidos que creemos deberán ajustarse a ello si queremos aparecer en los resultados”.

Alicia Rodríguez, Content Strategist de SEMrush para España y LATAM y editora del blog en español de SEMrush

Esta no deja de ser una prueba más de que el SEO, el marketing de buscadores y el marketing digital evolucionan constantemente. Con las actualizaciones del algoritmo de Google los sitios web fluctúan en las posiciones en los resultados de búsqueda. Cualquier sitio web puede subir a los primeros puestos o desaparecer con las actualizaciones. Y todos los profesionales del marketing (sobre todo los SEO Manager) deben actualizar sus conocimientos de forma constante para mantenerse al día e ir al rebufo de estos cambios.

Jesús de Matías Batalla (Alcalá de Henares, 1988). Periodista y escritor. Actualmente es CMO y Responsable de Contenidos y Comunicación Marketing Insider Review, además de consultor para Kanlli Agencia de Medios Digitales. Recientemente, ha sido redactor SEO y técnico SEM en la agencia de marketing 20lab Automotive. Ha trabajado como periodista en medios de comunicación como la agencia de noticias Europa Press, RNE, Actualidad Económica y Periódico Escuela. Ha sido Community Manager de varias empresas como Grupo Ariza y Érase un Gourmet. Autor de un poemario (Los versos del destierro) y una novela histórica (El último nazi irlandés).